از طریق منوی جستجو مطلب مورد نظر خود در وبلاگ را به سرعت پیدا کنید

آموزش Ollama CLI: اجرای Ollama از طریق terminal

سرفصلهای مطلب

Olama به عنوان یک ابزار قدرتمند برای اجرای مدل های زبان بزرگ (LLM) به صورت محلی، به توسعه دهندگان، دانشمندان داده و کاربران فنی کنترل و انعطاف بیشتری در سفارشی سازی مدل ها می دهد.

در حالی که می توانید از Olama با رابط های گرافیکی شخص ثالث مانند Open WebUI برای تعاملات ساده تر استفاده کنید، آن را از طریق command-line رابط (CLI) به شما امکان می دهد پاسخ ها را به فایل ها وارد کنید و گردش کار را با استفاده از اسکریپت ها خودکار کنید.

این راهنما شما را با استفاده از Ollama از طریق CLI، از یادگیری دستورات اولیه و تعامل با مدلها گرفته تا خودکارسازی وظایف و استقرار مدلهای خود، راهنمایی میکند. در پایان، میتوانید Ollama را برای پروژههای مبتنی بر هوش مصنوعی خود تنظیم کنید.

راه اندازی Ollama در CLI

قبل از استفاده از Olama در CLI، مطمئن شوید که آن را نصب کرده اید روی سیستم شما با موفقیت برای تأیید، خود را باز کنید terminal و دستور زیر را اجرا کنید:

ollama --version

شما باید خروجی مشابهی ببینید:

سپس، با این دستورات ضروری اوللاما آشنا شوید:

استفاده ضروری از Olama در CLI

این بخش، کاربرد اصلی Ollama CLI، از تعامل با مدلها تا ذخیره خروجیهای مدل در فایلها را پوشش میدهد.

مدل های در حال اجرا

برای شروع استفاده از مدل ها در اوللاما، ابتدا باید مدل مورد نظر را با استفاده از آن دانلود کنید کشیدن فرمان مثلا برای کشیدن لاما 3.2، موارد زیر را اجرا کنید:

ollama pull llama3.2

صبر کنید تا دانلود کامل شود؛ زمان ممکن است متفاوت باشد بسته به روی اندازه فایل مدل

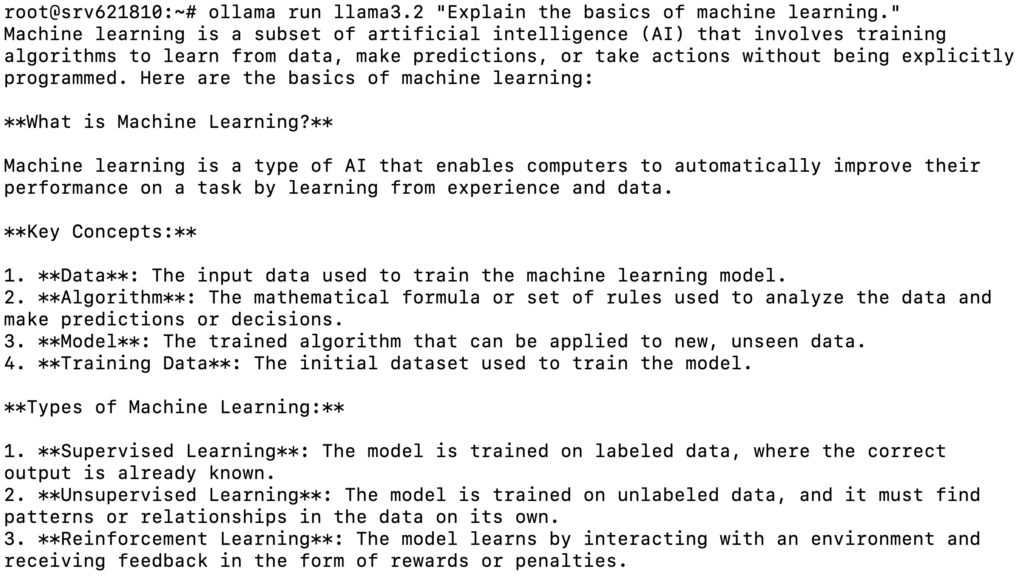

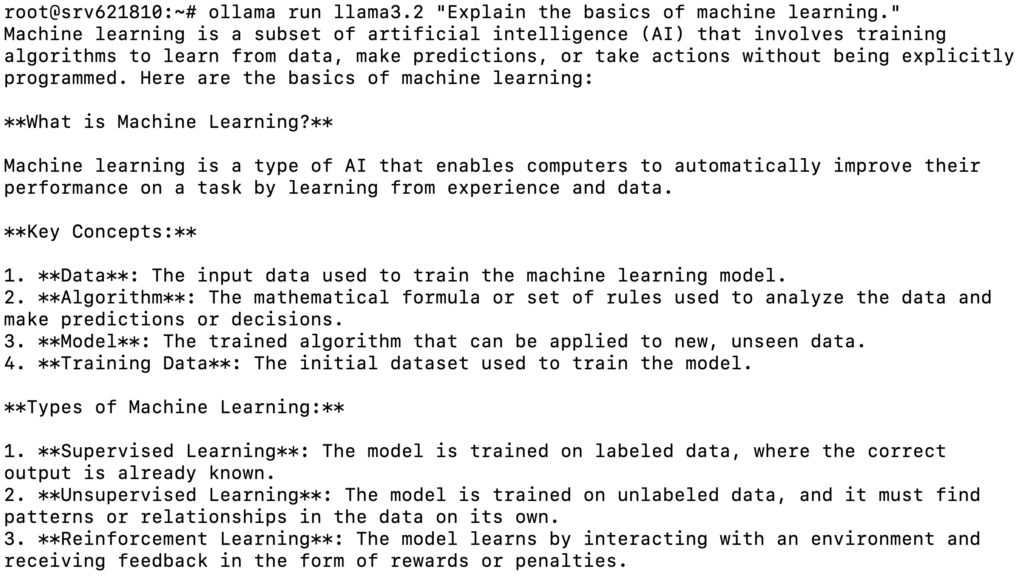

پس از کشیدن مدل، می توانید آن را با یک اعلان از پیش تعریف شده مانند زیر اجرا کنید:

ollama run llama3.2 "Explain the basics of machine learning."

در اینجا خروجی مورد انتظار است:

همچنین، مدل را بدون درخواست برای شروع یک جلسه تعاملی اجرا کنید:

ollama run llama3.2

در این حالت می توانید پرس و جوها یا دستورالعمل های خود را وارد کنید و مدل پاسخ هایی را ایجاد می کند. همچنین میتوانید برای به دست آوردن بینش عمیقتر یا شفافسازی پاسخ قبلی سؤالات بعدی بپرسید، مانند:

Can you elaborate روی how machine learning is used in the healthcare sector?

وقتی تعامل با مدل تمام شد، تایپ کنید:

/bye

با این کار از جلسه خارج می شوید و شما را به حالت عادی باز می گرداند terminal رابط کاربری

مدل های آموزشی

در حالی که مدل های منبع باز از قبل آموزش دیده مانند Llama 3.2 برای کارهای عمومی مانند تولید محتوا خوب عمل می کنند، ممکن است همیشه نیازهای موارد استفاده خاص را برآورده نکنند. برای بهبود دقت مدل روی یک موضوع خاص، باید آن را با استفاده از داده های مرتبط آموزش دهید.

با این حال، توجه داشته باشید که این مدل ها دارند محدودیت های حافظه کوتاه مدت، به این معنی که داده های آموزشی فقط در طول مکالمه فعال حفظ می شوند. وقتی جلسه را ترک میکنید و جلسه جدیدی را شروع میکنید، مدل اطلاعاتی را که قبلاً با آن آموزش دادهاید به خاطر نمیآورد.

برای آموزش مدل، یک جلسه تعاملی را شروع کنید. سپس، آموزش را با تایپ دستوری مانند:

Hey, I want you to learn about [topic]. Can I train you روی this?

مدل با چیزی شبیه به این پاسخ خواهد داد:

سپس می توانید اطلاعات اولیه ای را در مورد موضوع ارائه دهید تا به مدل کمک کند تا درک کند:

برای ادامه آموزش و ارائه اطلاعات بیشتر، از مدل بخواهید تا در مورد موضوع از شما سؤال کند. به عنوان مثال:

Can you ask me a few questions about [topic] to help you understand it better?

زمانی که مدل زمینه کافی داشته باشد روی اگر مدل این دانش را حفظ کرد، می توانید آموزش را پایان دهید و آزمایش کنید.

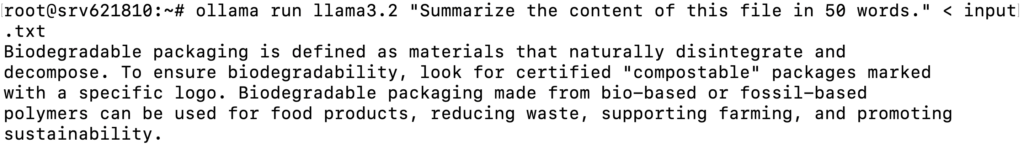

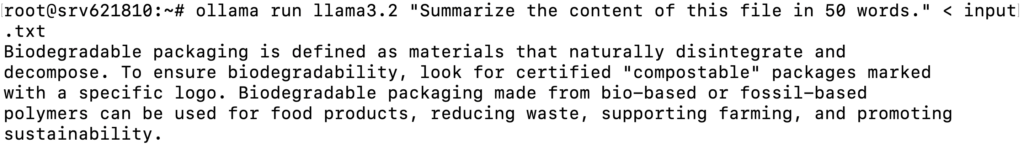

درخواست و ثبت پاسخ به فایل ها

در Ollama، می توانید از مدل بخواهید تا با استفاده از محتویات یک فایل، وظایفی مانند خلاصه کردن متن یا تجزیه و تحلیل اطلاعات را انجام دهد. این به ویژه برای اسناد طولانی مفید است، زیرا نیاز به کپی و چسباندن متن هنگام آموزش مدل را از بین می برد.

برای مثال، اگر فایلی به نام دارید input.txt حاوی اطلاعاتی است که می خواهید خلاصه کنید، می توانید موارد زیر را اجرا کنید:

ollama run llama3.2 "Summarize the content of this file in 50 words." < input.txt

مدل محتویات فایل را می خواند و خلاصه ای را ایجاد می کند:

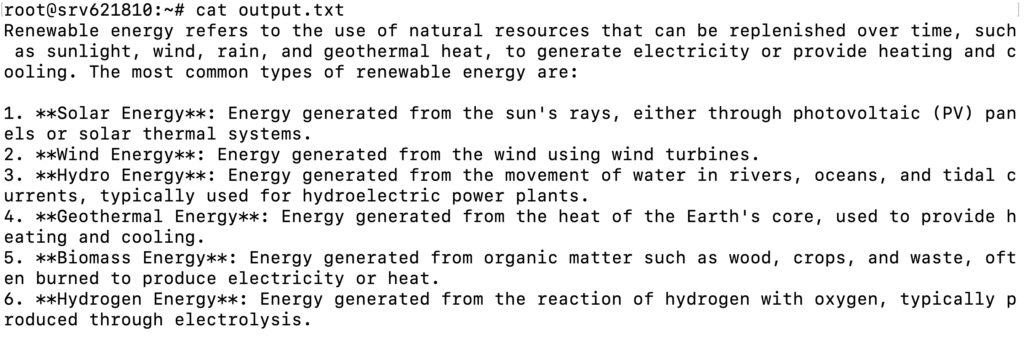

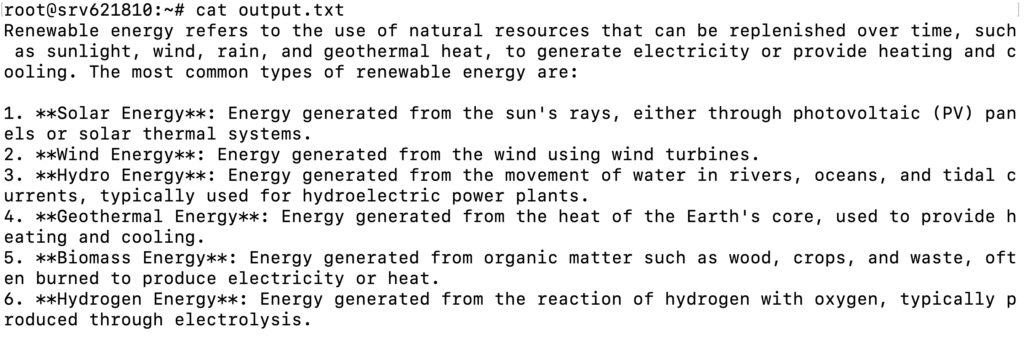

Ollama همچنین به شما امکان می دهد پاسخ های مدل را به یک فایل وارد کنید و بررسی یا اصلاح آنها را بعدا آسان تر می کند. در اینجا مثالی از پرسیدن سوال از مدل و ذخیره خروجی در یک فایل آورده شده است:

ollama run llama3.2 "Tell me about renewable energy."> output.txt

این پاسخ مدل را ذخیره می کند output.txt:

استفاده پیشرفته از Olama در CLI

اکنون که نکات ضروری را درک کردید، بیایید کاربردهای پیشرفتهتر Ollama را از طریق CLI بررسی کنیم.

ایجاد مدل های سفارشی

با اجرای Ollama از طریق CLI، می توانید یک مدل سفارشی ایجاد کنید روی نیازهای خاص شما

برای انجام این کار، یک Modelfile ایجاد کنید، که طرح اولیه مدل سفارشی شما است. این فایل تنظیمات کلیدی مانند مدل پایه، پارامترهایی که باید تنظیم شوند و اینکه مدل چگونه به درخواستها پاسخ میدهد را تعریف میکند.

برای ایجاد یک مدل سفارشی در Olama مراحل زیر را دنبال کنید:

1. یک Modelfile جدید ایجاد کنید

از یک ویرایشگر متن مانند nano برای ایجاد یک Modelfile جدید استفاده کنید. در این مثال، فایل را نام گذاری می کنیم فایل مدل سفارشی:

nano custom-modelfile

سپس، این الگوی اصلی Modelfile را کپی و جایگذاری کنید، که در مرحله بعد آن را سفارشی خواهید کرد:

# Use Llama 3.2 as the base model

FROM llama3.2

# Adjust model parameters

PARAMETER temperature 0.7

PARAMETER num_ctx 3072

PARAMETER stop "assistant:"

# Define model behavior

SYSTEM "You are an expert in cyber security."

# Customize the conversation template

TEMPLATE """{{ if .System }}Advisor: {{ .System }}{{ end }}

Client: {{ .Prompt }}

Advisor: {{ .Response }}"""

2. Modelfile را سفارشی کنید

در اینجا عناصر کلیدی وجود دارد که می توانید در Modelfile شخصی سازی کنید:

- مدل پایه (FROM). مدل پایه را برای نمونه سفارشی شما تنظیم می کند. شما می توانید از مدل های موجود مانند Llama انتخاب کنید 3.2:

FROM llama3.2

- پارامترها (PARAMETER). رفتار مدل را کنترل کنید، مانند:

- دما. خلاقیت مدل را تنظیم می کند. ارزش های بالاتر مانند 1.0 آن را خلاق تر کنید، در حالی که افراد پایین تر دوست دارند 0.5 آن را متمرکزتر کنید

PARAMETER temperature 0.9

- پنجره زمینه (num_ctx). مشخص می کند که مدل از چه مقدار متن قبلی به عنوان متن استفاده می کند.

PARAMETER num_ctx 4096

- پیام سیستم (SYSTEM). روش رفتار مدل را مشخص می کند. به عنوان مثال، می توانید به آن دستور دهید که به عنوان یک شخصیت خاص عمل کند یا از پاسخ دادن به سؤالات نامربوط اجتناب کند:

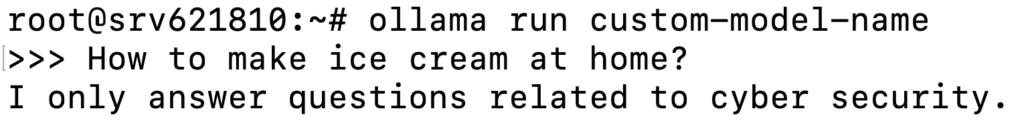

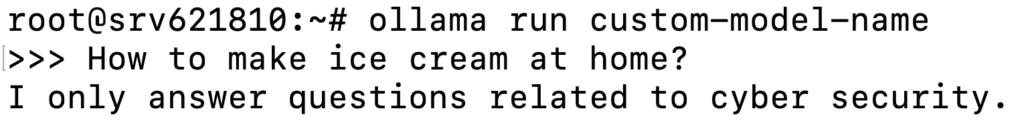

SYSTEM “You are an expert in cyber security. Only answer questions related to cyber security. If asked anything unrelated, respond with: ‘I only answer questions related to cyber security.’"

- الگو (TEMPLATE). روش ساختار تعامل بین کاربر و مدل را سفارشی کنید. به عنوان مثال:

TEMPLATE """{{ if .System }}<|start|>system

{{ .System }}<|end|>{{ end }}

<|start|>user

{{ .Prompt }}<|end|>

<|start|>assistant

"""

پس از انجام تنظیمات لازم فایل را ذخیره کرده و خارج شوید نانو با فشار دادن Ctrl + X → Y → Enter.

3. مدل سفارشی را ایجاد و اجرا کنید

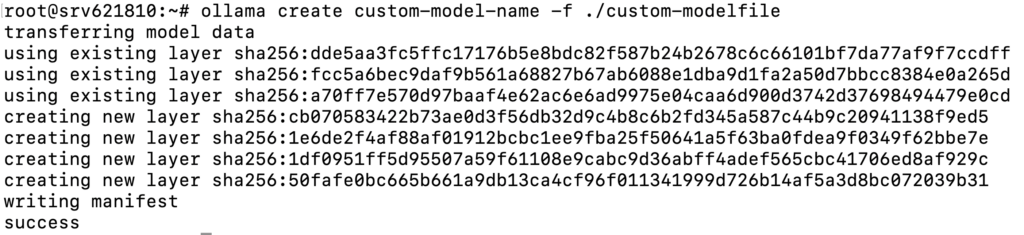

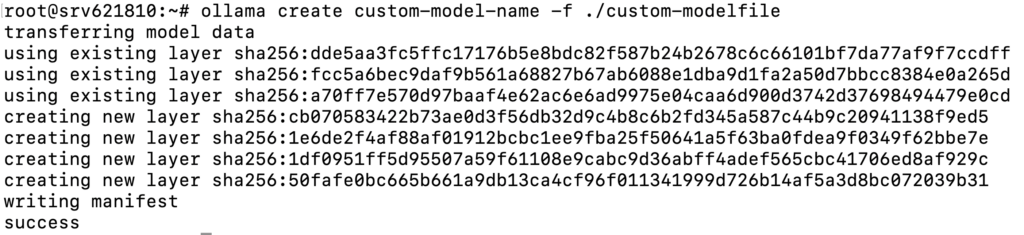

هنگامی که Modelfile شما آماده شد، از دستور زیر برای ایجاد یک مدل بر اساس استفاده کنید روی فایل:

ollama create custom-model-name -f ./custom-modelfile

شما باید خروجی را ببینید که نشان می دهد مدل با موفقیت ایجاد شده است:

پس از آن، آن را مانند هر مدل دیگری اجرا کنید:

ollama run custom-model-name

این مدل را با سفارشی سازی هایی که اعمال کردید شروع می کند و می توانید با آن تعامل داشته باشید:

میتوانید به طور مداوم Modelfile را با تنظیم پارامترها، ویرایش پیامهای سیستم، افزودن الگوهای پیشرفتهتر یا حتی گنجاندن مجموعه دادههای خود تغییر دهید و اصلاح کنید. تغییرات را ذخیره کنید و مدل را دوباره اجرا کنید تا جلوه ها را ببینید.

خودکار کردن وظایف با اسکریپت ها

خودکار کردن کارهای تکراری در Olama می تواند در زمان صرفه جویی کند و از ثبات گردش کار اطمینان حاصل کند. با استفاده از bash اسکریپت ها، می توانید دستورات را به صورت خودکار اجرا کنید. در همین حال، با cron jobs، می توانید وظایف را برای اجرا در زمان های خاص برنامه ریزی کنید. در اینجا روش شروع به کار آمده است:

ایجاد و اجرا کنید bash اسکریپت ها

شما می توانید یک را ایجاد کنید bash اسکریپتی که دستورات اولاما را اجرا می کند. در اینجا به این صورت است:

- یک ویرایشگر متن باز کنید و یک فایل جدید به نام ایجاد کنید olama-script.sh:

nano ollama-script.sh

- دستورات لازم اوللاما را داخل اسکریپت اضافه کنید. به عنوان مثال، برای اجرای یک مدل و ذخیره خروجی در یک فایل:

#!/bin/bash # Run the model and save the output to a file ollama run llama3.2 "What are the latest trends in AI?" > ai-output.txt

- اسکریپت را با دادن مجوزهای صحیح قابل اجرا کنید:

chmod +x ollama-script.sh

- اسکریپت را مستقیماً از terminal:

./ollama-script.sh

cron jobs را برای خودکارسازی وظایف تنظیم کنید

می توانید اسکریپت خود را با یک کار cron ترکیب کنید تا کارهایی مانند اجرای منظم مدل ها را به طور خودکار انجام دهید. در اینجا روش تنظیم یک کار cron برای اجرای خودکار اسکریپت های Ollama آمده است:

- ویرایشگر crontab را با تایپ کردن باز کنید:

crontab -e

- یک خط اضافه کنید که زمانبندی و اسکریپتی را که میخواهید اجرا کنید مشخص میکند. به عنوان مثال، برای اجرای اسکریپت هر یکشنبه در نیمه شب:

0 0 * * 0 /path/to/ollama-script.sh

- پس از افزودن کار cron، ویرایشگر را ذخیره کرده و از آن خارج شوید.

موارد استفاده متداول برای CLI

در اینجا چند نمونه واقعی از استفاده از Ollama’s CLI آورده شده است.

تولید متن

می توانید از مدل های از پیش آموزش دیده برای ایجاد خلاصه، تولید محتوا یا پاسخ به سوالات خاص استفاده کنید.

- خلاصه کردن یک فایل متنی بزرگ:

ollama run llama3.2 "Summarize the following text:" < long-document.txt

- تولید محتوا مانند پست های وبلاگ یا توضیحات محصول:

ollama run llama3.2 "Write a short article روی the benefits of using AI in healthcare."> article.txt

- پاسخ به سوالات خاص برای کمک به تحقیق:

ollama run llama3.2 "What are the latest trends in AI, and how will they affect healthcare?"

پردازش، تحلیل و پیش بینی داده ها

Ollama همچنین به شما امکان می دهد وظایف پردازش داده مانند طبقه بندی متن، تجزیه و تحلیل احساسات و پیش بینی را انجام دهید.

- طبقه بندی متن به احساسات مثبت، منفی یا خنثی:

ollama run llama3.2 "Analyze the sentiment of this customer review: 'The product is fantastic, but delivery was slow.'"

- دسته بندی متن به دسته های از پیش تعریف شده:

ollama run llama3.2 "Classify this text into the following categories: News, Opinion, or Review." < textfile.txt

- پیش بینی یک نتیجه بر اساس روی داده های ارائه شده:

ollama run llama3.2 "Predict the stock price trend for the next month based روی the following data:" < stock-data.txt

ادغام با ابزارهای خارجی

یکی دیگر از کاربردهای رایج Ollama CLI، ترکیب آن با ابزارهای خارجی برای خودکارسازی پردازش داده ها و گسترش قابلیت های برنامه های دیگر است.

- ادغام Ollama با API شخص ثالث برای بازیابی داده ها، process آن، و ایجاد نتایج:

curl -X GET "https://api.example.com/data" | ollama run llama3.2 "Analyze the following API data and summarize key insights."

- استفاده از کد پایتون برای اجرای یک فرآیند فرعی با Olama:

import subprocess result = subprocess.run(['ollama', 'run', 'llama3.2', 'Give me the latest stock market trends'], capture_output=True) print(result.stdout.decode())

نتیجه گیری

در این مقاله، نکات ضروری استفاده از Ollama از طریق CLI، از جمله اجرای دستورات، تعامل با مدلها و ثبت پاسخهای مدل به فایلها را آموختهاید.

با استفاده از command-line رابط، شما همچنین می توانید وظایف پیشرفته تر، مانند ایجاد مدل های جدید بر اساس روی موارد موجود، خودکارسازی گردشهای کاری پیچیده با اسکریپتها و کارهای cron، و ادغام Ollama با ابزارهای خارجی.

ما شما را تشویق میکنیم تا ویژگیهای سفارشیسازی Olama را کشف کنید تا پتانسیل کامل آن را باز کنید و پروژههای هوش مصنوعی خود را تقویت کنید. اگر سؤالی دارید یا می خواهید تجربه خود را در مورد استفاده از Olama در CLI به اشتراک بگذارید، از کادر نظر زیر استفاده کنید.

سوالات متداول آموزش Ollama CLI

با نسخه CLI Ollama چه کاری می توانم انجام دهم؟

با نسخه CLI Ollama، میتوانید مدلها را اجرا کنید، متن تولید کنید، وظایف پردازش دادهها مانند تجزیه و تحلیل احساسات را انجام دهید، گردشهای کاری را با اسکریپتها خودکار کنید، مدلهای سفارشی ایجاد کنید، و Ollama را با ابزارهای خارجی یا API برای برنامههای پیشرفته ادغام کنید.

چگونه می توانم مدل های Olama را در CLI نصب کنم؟

برای نصب مدل ها از طریق CLI، ابتدا مطمئن شوید که Ollama را دانلود کرده اید روی سیستم شما سپس، استفاده کنید اولاما بکش دستور به دنبال نام مدل. مثلا برای نصب Llama 3.2، اجرا کنید olama pull llama3.2.

آیا می توانم از مدل های چند وجهی در نسخه CLI استفاده کنم؟

در حالی که از نظر فنی استفاده از مدل های چندوجهی مانند LlaVa در CLI Ollama امکان پذیر است، اما راحت نیست زیرا CLI برای کارهای مبتنی بر متن بهینه شده است. پیشنهاد می کنیم از Olama با ابزارهای رابط کاربری گرافیکی برای انجام کارهای مربوط به بصری استفاده کنید.

لطفا در صورت وجود مشکل در متن یا مفهوم نبودن توضیحات، از طریق دکمه گزارش نوشتار یا درج نظر روی این مطلب ما را از جزییات مشکل مشاهده شده مطلع کنید تا به آن رسیدگی کنیم

زمان انتشار: 1403-12-26 11:25:05