از طریق منوی جستجو مطلب مورد نظر خود در وبلاگ را به سرعت پیدا کنید

روش نصب GPT4All روی اوبونتو

سرفصلهای مطلب

GPT4All مبتنی است روی LLaMa و GPT-J. این ابزارهای انعطاف پذیر و قدرتمند هوش مصنوعی را برای برنامه های مختلف ارائه می دهد. دادههای آموزشی برای GPT4All کوچکتر از دادههای آموزشی مدلهای GPT3 و GPT4 است که به این معنی است که این محدودیت باعث میشود این مدل در مقایسه با سایر مدلها از نظر قابلیت محدود باشد. علاوه بر این، این مدل اجرا می شود روی ماشین های محلی، بنابراین ممکن است کندتر باشد، و این بستگی دارد روی قابلیت های پردازش و سرعت سیستم (CPU).

کار کردن روی مدل GPT4All

GPT4All دارای اتصالات پایتون برای هر دو رابط GPU و CPU است که به کاربران کمک می کند تا با استفاده از اسکریپت های Python با مدل GPT4All تعامل ایجاد کرده و این مدل را در چندین برنامه ادغام کنند. این مدل همچنین به گسترش دامنه مدلهای زبان موجود و مدلهای پیشرفته سازگار کمک میکند. برای بزرگتر کردن این جامعه، از توسعه دهندگان قدردانی می شود که درخواست های جذب برای مشارکت غیرمستقیم در پروژه ارائه دهند.

این مقاله گام به گام ارائه می دهد process برای نصب GPT4All روی اوبونتو و نصب سایر بسته های لازم برای تولید پاسخ با استفاده از مدل GPT4All. شروع به کار با مدل GPT4All ابتدا نیاز به نصب اجزای اجباری دارد. مطمئن شوید که پایتون از قبل نصب شده باشد روی سیستم های شما نسخه پیشنهادی پایتون نسخه 3.7 یا نسخههایی است که بعداً به آن میآیند. پس از آن، ما ملزم به انجام مراحل زیر هستیم:

مراحل نصب

- ابتدا، با دانلود مخزن GPT4All از GitHub شروع کنید. لینک این وب سایت در اینجا ذکر شده است https://github.com/nomic-ai/gpt4all.git”. در ادامه این مرحله، نصب کننده GPT4All را برای سیستم عامل های مربوطه خود از وب سایت رسمی GPT4All دانلود می کنیم.

- فایل های دانلود شده را در هر دایرکتوری فایلی استخراج کنید روی سیستم ما

- خط فرمان یا terminal پنجره را باز کنید و به دایرکتوری GPT4All بروید که در آنجا فایل های دانلود شده را استخراج می کنیم.

- سپس دستور نصب بسته پایتون مورد نیاز را اجرا کنید.

مرحله 1: نصب

برای دانلود و نصب نیازمندی های بسته های پایتون و نصب GPT4All، دستور زیر را برای شروع نصب اجرا کنید:

مرحله 2: مدل GPT4All را دانلود کنید

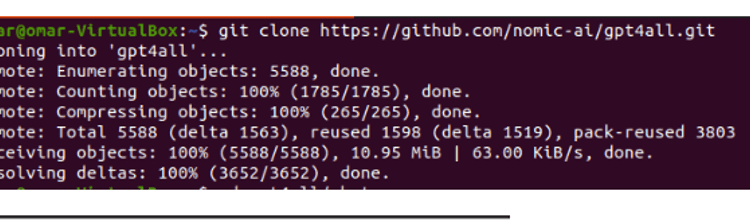

یا می توانیم مخزن GitHub را از لینک وب سایت GPT4All دانلود یا شبیه سازی کنیم. برای کلون کردن مخزن، دستور زیر را اجرا کنید:

این دستور همانطور که در قطعه زیر نشان داده شده است، مخزن GPT4All را در ماشین های محلی ما کلون می کند:

اگر از لینک ارائه شده برای دانلود نصب کننده GPT4All استفاده کرده ایم، باید مطمئن شویم که فایل مدل با پسوند .bin باشد. سپس، باید این فایل دانلود شده را در پوشه دایرکتوری چت که در آن GPT4All دانلود می شود، قرار دهیم.

مرحله 3: نقطه بازرسی مدل (اختیاری و فقط زمانی که مخزن را کلون کردیم قابل استفاده است)

اگر مخزن GPT4All را از پنجره فرمان (اوبونتو) کلون کردیم، باید فایل “.bin extension” را دانلود کنیم. برای این منظور افزونه را مستقیما از این لینک دانلود می کنیم.https://the-eye.eu/public/AI/models/nomic-ai/gpt4all/gpt4all-lora-quantized.bin“.

پس از دانلود، این فایل را به پوشه چت که در مخزن کلون شده موجود است منتقل کنید.

مرحله 4: فایل را به پوشه چت منتقل کنید

اکنون باید به پوشه چت بروید. وقتی داریم کار می کنیم روی اوبونتو، باید دستور زیر را اجرا کنیم که ما را به پوشه چت هدایت می کند. دستور به شرح زیر ذکر شده است:

یا مستقیماً نصب کننده GPT4ll را از وب سایت GPT4All دانلود کردیم یا مخزن را کلون کردیم. در این مرحله، ما باید باشیم روی همان مرحله که در آن مخزن GPT4ALL را با موفقیت دانلود کردیم و فایل دانلودی “.bin extension” آن را در دایرکتوری چت در پوشه “GPT4All” قرار دادیم.

مرحله 5: مدل را اجرا کنید

وقتی به پوشه چت رفتیم، اکنون زمان اجرای مدل است. دستور زیر را اجرا می کنیم روی لینوکس terminal:

دستور شروع به اجرای مدل برای GPT4All می کند. اکنون میتوانیم از این مدل برای تولید متن از طریق تعامل با این مدل با استفاده از خط فرمان یا the استفاده کنیم terminal پنجره یا ما ممکن است به سادگی هر پرس و جوی متنی را که ممکن است داشته باشیم وارد کنیم و منتظر باشیم تا مدل به آن پاسخ دهد. این مدل بسته به زمان پردازش ممکن است کمی طول بکشد روی مشخصات سیستم ما اما مزیتی که این مدل دسکتاپ نسبت به مدل های موجود دارد روی ابر این است که از آنجایی که اکنون این مدل را اجرا می کنیم، دیگر نگران مشکلات شبکه نخواهیم بود روی سخت افزار محلی

ما با موفقیت GPT4all را اجرا کردیم روی ماشین محلی ما به خاطر داشته باشید که GPT4All هنوز در مراحل بهبود است، بنابراین ما باید اقساط خود را به روز نگه داریم. مخزن GPT4All را می توان به راحتی در هر زمان به روز کرد. تنها کاری که باید انجام دهیم این است که به پوشه نصب اصلی مدل GPT4All برویم و به سادگی “Git pull” را درخواست کنیم. این مدل هنوز به دقت عملکرد ChatGPT دست پیدا نکرده است، اما هنوز با ارائه یک رابط دسکتاپ به کاربران خود از آن مدل ها متمایز است.

نتیجه

جایگزین مقیاس بزرگ، به راحتی در دسترس و منبع باز برای مدل هوش مصنوعی که مشابه GPT3 است، “GPT4ALL” است. روش گام به گامی که در این راهنما توضیح دادیم را می توان برای استفاده از قدرت این مدل برای برنامه ها و پروژه های خود دنبال کرد. این مقاله روشن می کند روی روش نصب مدل GPT4All در اوبونتو. ما به طور مفصل درباره روش کار این مدل با جوانب مثبت و منفی که به آن ضمیمه شده است بحث کردیم.

لطفا در صورت وجود مشکل در متن یا مفهوم نبودن توضیحات، از طریق دکمه گزارش نوشتار یا درج نظر روی این مطلب ما را از جزییات مشکل مشاهده شده مطلع کنید تا به آن رسیدگی کنیم

زمان انتشار: 1402-12-28 18:50:03