از طریق منوی جستجو مطلب مورد نظر خود در وبلاگ را به سرعت پیدا کنید

روش نصب و پیکربندی Apache Hadoop روی اوبونتو

سرفصلهای مطلب

اجزای اصلی Apache Hadoop عبارتند از:

- HDFS: در Apache Hadoop، HDFS یک سیستم فایل است که در گره های متعددی توزیع می شود.

- MapReduce: چارچوبی برای توسعه برنامه هایی است که حجم عظیمی از داده ها را مدیریت می کنند.

- Hadoop Common: مجموعه ای از کتابخانه ها و ابزارهای مورد نیاز ماژول های Hadoop است.

- نخ هادوپ: در Hadoop، Hadoop Yarn لایه های منابع را مدیریت می کند.

اکنون، روش های ارائه شده در زیر را بررسی کنید نصب و پیکربندی Apache Hadoop روی سیستم اوبونتو شما. پس بیایید شروع کنیم!

روش نصب Apache Hadoop روی اوبونتو

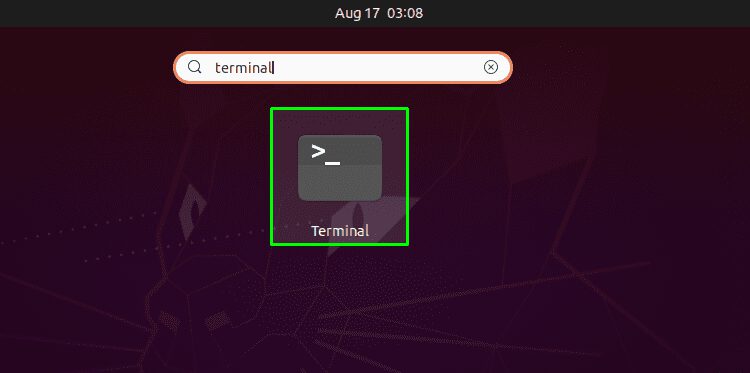

اول از همه، ما اوبونتو را باز می کنیم terminal با فشار دادن “CTRL+ALT+T“، همچنین می توانید تایپ کنید “terminal” در نوار جستجوی برنامه به شرح زیر است:

مرحله بعدی به روز رسانی مخازن سیستم است:

حالا ما نصب می کنیم جاوا روی سیستم اوبونتو ما با نوشتن دستور زیر در terminal:

وارد “y/Y” برای اجازه نصب process ادامه:

حال، وجود جاوای نصب شده را با بررسی نسخه آن تأیید کنید:

ما یک کاربر جداگانه برای اجرای Apache Hadoop ایجاد خواهیم کرد روی سیستم ما با استفاده از “اضافه کننده” دستور:

رمز عبور کاربر جدید، نام کامل آن و سایر اطلاعات را وارد کنید. تایپ کنید “y/Y” برای تأیید صحت اطلاعات ارائه شده:

وقت آن رسیده است که کاربر فعلی را با کاربر ایجاد شده Hadoop تغییر دهید، که این است.hadoopuser” در مورد ما:

اکنون، از دستور زیر برای تولید جفت کلید خصوصی و عمومی استفاده کنید:

آدرس فایلی را که می خواهید جفت کلید را در آن ذخیره کنید وارد کنید. پس از این، یک عبارت عبور اضافه کنید که قرار است در کل تنظیمات کاربر Hadoop استفاده شود:

بعد، این جفت کلید را به ssh authorized_keys اضافه کنید:

همانطور که جفت کلید تولید شده را در کلید مجاز ssh ذخیره کرده ایم، اکنون مجوزهای فایل را به ” تغییر می دهیم.640” به این معنی که فقط ما به عنوان ”مالک” فایل دارای مجوز خواندن و نوشتن خواهد بود،گروه ها” فقط مجوز خواندن را خواهد داشت. هیچ مجوزی به «سایر کاربران”:

حالا احراز هویت localhost با نوشتن دستور زیر:

از موارد زیر استفاده کنید wget دستور نصب چارچوب Hadoop برای سیستم شما:

دانلود شده را استخراج کنیدhadoop-3.3.0.tar.gz” فایل با دستور tar:

شما همچنین می توانید نام دایرکتوری استخراج شده را تغییر دهید، همانطور که ما با اجرای دستور زیر انجام می دهیم:

اکنون، متغیرهای محیط جاوا را برای راه اندازی Hadoop پیکربندی کنید. برای این، ما موقعیت مکانی خود را بررسی خواهیم کردJAVA_HOME” متغیر:

باز کن “~/.bashrc” فایل در ” شمانانو” ویرایشگر متن:

مسیرهای زیر را در قسمت باز شده اضافه کنید~/.bashrc” فایل:

export HADOOP_HOME=/خانه/hadoopuser/هادوپ

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export HADOOP_YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/بومی

export مسیر=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/صندوقچه

export HADOOP_OPTS=“-Djava.library.path=$HADOOP_HOME/lib/native”

پس از آن، ” را فشار دهیدCTRL+O” برای ذخیره تغییراتی که در فایل ایجاد کردیم:

اکنون دستور زیر را بنویسید تا “JAVA_HOME” متغیر محیطی:

کاری که باید انجام دهیم این است که فایل متغیر محیطی Hadoop را باز کنیم:

ما باید خودمان را تنظیم کنیمJAVA_HOME” متغیر در محیط Hadoop:

دوباره ” را فشار دهیدCTRL+O” برای ذخیره محتوای فایل:

چگونه Apache Hadoop را پیکربندی کنیم روی اوبونتو

تا این مرحله، JAVA و Hadoop را با موفقیت نصب کردهایم، کاربران Hadoop را ایجاد کردهایم، احراز هویت مبتنی بر کلید SSH را پیکربندی کردهایم. در حال حاضر، ما به جلو حرکت می کنیم تا به شما نشان دهیم چگونه Apache Hadoop را پیکربندی کنیم روی اوبونتو سیستم. برای این، مرحله ایجاد دو دایرکتوری است: datanode و نام گره، داخل فهرست اصلی Hadoop:

ما Hadoop را به روز خواهیم کردcore-site.xml” را با اضافه کردن نام میزبان خود، فایل کنید، بنابراین ابتدا نام میزبان سیستم خود را با اجرای این دستور تأیید کنید:

اکنون، “core-site.xml” فایل در ” شمانانو” ویرایشگر:

نام میزبان سیستم ما در “linuxhit-VBoxمی توانید خطوط زیر را با system’s اضافه کنید host نام در فایل Hadoop “core-site.xml” باز شده:

<ویژگی>

<نام>fs.defaultFSنام>

<ارزش>hdfs://hadoop.linuxint-VBox.com:9000ارزش>

ویژگی>

پیکربندی>

مطبوعات “CTRL+O” و فایل را ذخیره کنید:

در “hdfs-site.xmlفایل ” مسیر دایرکتوری ” را تغییر می دهیمdatanode” و ”نام گره”:

<ویژگی>

<نام>dfs.replicationنام>

<ارزش>1ارزش>

ویژگی>

<ویژگی>

<نام>dfs.name.dirنام>

<ارزش>فایل:///خانه/hadoopuser/hadoopdata/hdfs/نام گرهارزش>

ویژگی>

<ویژگی>

<نام>dfs.data.dirنام>

<ارزش>فایل:///خانه/hadoopuser/hadoopdata/hdfs/datanodeارزش>

ویژگی>

پیکربندی>

دوباره برای نوشتن کد اضافه شده در فایل، دکمه “CRTL+O”:

بعد، «mapred-site.xml” را فایل کنید و کد زیر را در آن اضافه کنید:

<ویژگی>

<نام>mapreduce.framework.nameنام>

<ارزش>نخارزش>

ویژگی>

پیکربندی>

مطبوعات “CTRL+O” برای ذخیره تغییراتی که در فایل ایجاد کرده اید:

آخرین فایلی که باید بهروزرسانی شود، «yarn-site.xml“. این فایل Hadoop را در ” باز کنیدنانو” ویرایشگر:

خطوط داده شده زیر را در ” بنویسیدyarn-site.xml” فایل:

<ویژگی>

<نام>yarn.nodemanager.aux-servicesنام>

<ارزش>mapreduce_shuffleارزش>

ویژگی>

پیکربندی>

ما باید خوشه Hadoop را برای عملیات Hadoop راه اندازی کنیم. برای این کار، ما «نام گره” اولین:

اکنون خوشه Hadoop را با نوشتن دستور زیر در خود شروع کنید terminal:

در process برای شروع خوشه Hadoop، اگر “می تواند خطای نام میزبان را برطرف کند“، سپس باید نام میزبان را در ” مشخص کنید/و غیره/host” فایل:

ذخیره “/و غیره/host” فایل، و اکنون همه شما آماده شروع خوشه Hadoop هستید:

در مرحله بعد، ما “نخ” سرویس هادوپ:

اجرای دستور بالا خروجی زیر را به شما نشان می دهد:

برای بررسی وضعیت تمام سرویس های Hadoop، “jps” فرمان در شما terminal:

خروجی نشان می دهد که همه سرویس ها با موفقیت اجرا می شوند:

هادوپ در بندر گوش می دهد 8088 و 9870، بنابراین شما باید به این پورت ها از طریق فایروال اجازه دهید:

اکنون تنظیمات فایروال را دوباره بارگیری کنید:

اکنون، مرورگر خود را باز کنید و به Hadoop خود دسترسی پیدا کنید.نام گره” با وارد کردن آدرس IP خود با پورت 9870:

از پورت استفاده کنید8080” با آدرس IP خود برای دسترسی به مدیر منابع Hadoop:

در رابط وب Hadoop، می توانید به دنبال “فهرست راهنما را مرور کنیدبا اسکرول کردن وب باز شده به پایین page به شرح زیر است:

همه چیز در مورد نصب و پیکربندی Apache Hadoop بود روی سیستم اوبونتو برای متوقف کردن خوشه Hadoop، باید خدمات ” را متوقف کنید.نخ” و ”نام گره”:

نتیجه

برای برنامه های مختلف داده های بزرگ، آپاچی هادوپ یک پلت فرم رایگان در دسترس برای مدیریت، ذخیره و پردازش داده ها است که عمل می کند روی سرورهای خوشه ای این یک سیستم فایل توزیع شده مقاوم در برابر خطا است که امکان پردازش موازی را فراهم می کند. در Hadoop، مدل MapReduce برای ذخیره و استخراج داده ها از گره های آن استفاده می شود. در این مقاله روش را به شما نشان داده ایم برای نصب و پیکربندی Apache Hadoop روی سیستم اوبونتو شما

لطفا در صورت وجود مشکل در متن یا مفهوم نبودن توضیحات، از طریق دکمه گزارش نوشتار یا درج نظر روی این مطلب ما را از جزییات مشکل مشاهده شده مطلع کنید تا به آن رسیدگی کنیم

زمان انتشار: 1403-01-02 00:17:04